Kommt "Skynet"?

IT-Experten warnen vor künstlicher Intelligenz

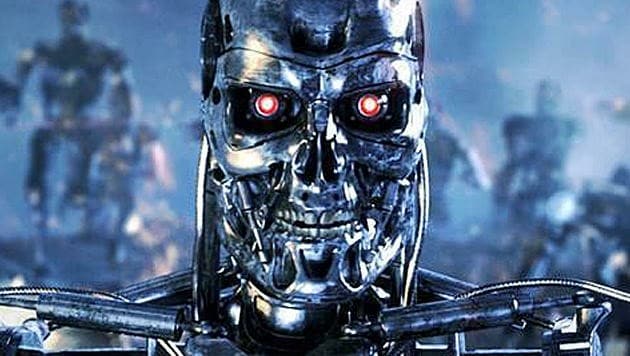

Was passiert, wenn eine mächtige künstliche Intelligenz die Kontrolle übernimmt und die Maschinen rebellieren, weiß jeder, der schon einmal den Action-Hit "Terminator" gesehen hat. Geht es nach den Wissenschaftlern, die jetzt vor den Gefahren durch KI warnen, muss es aber nicht gleich "Skynet" sein. Selbstfahrende Autos oder autonome Waffensysteme könnten schon in naher Zukunft zur Gefahr werden, berichtet "Heise".

Was, wenn KI über Leben und Tod entscheidet?

Der Vormarsch intelligenter Maschinen führe zu einer Vielzahl von ethischen Problemen, so die Befürchtung der Unterzeichner. Bei selbstfahrenden Autos gebe es beispielsweise die Herausforderung für KI-Programmierer, das Auto in einer unvermeidlichen Unfallsituation zur richtigen Verhaltensweise zu "erziehen".

Droht eine Kollision, bei der entweder ein älterer Mensch oder ein Kind überfahren wird, muss die Software des Autos in Sekundenbruchteilen entscheiden, in welche Richtung das Fahrzeug lenkt. Droht ein Unfall, bei dem zwischen Personen- und Sachschaden zu entscheiden ist, muss das Auto ebenfalls eine Entscheidung treffen. Das führt zu neuen ethischen Problemen bei der Entwicklung autonomer Systeme.

Kennen autonome Waffen Menschenrechte?

Aber nicht nur im Automobilbereich sehen die Unterzeichner des Briefes – unter ihnen Größen der Wissenschaft und Technik wie Tesla-Chef Elon Musk und der Physiker Stephen Hawking – Gefahren. Was, wenn wir autonome Waffensysteme wie Drohnen entwickeln und der KI-Programmierer vergisst, sie die Menschenrechte achten zu lassen?

Diese und ähnliche Fragen sollten Wissenschaftler, die an KI arbeiten, stets im Hinterkopf behalten, heißt es in dem offenen Brief des "Future of Life"-Institus. Denn nur, wenn alle Eventualitäten berücksichtigt würden und die Schöpfer der autonomen Geräte der Zukunft sich ihrer Verantwortung bewusst seien, könnten böse Überraschungen vermieden werden.

krone.tv

Mehr Web

Kommentare

Da dieser Artikel älter als 18 Monate ist, ist zum jetzigen Zeitpunkt kein Kommentieren mehr möglich.

Wir laden Sie ein, bei einer aktuelleren themenrelevanten Story mitzudiskutieren: Themenübersicht.

Bei Fragen können Sie sich gern an das Community-Team per Mail an forum@krone.at wenden.