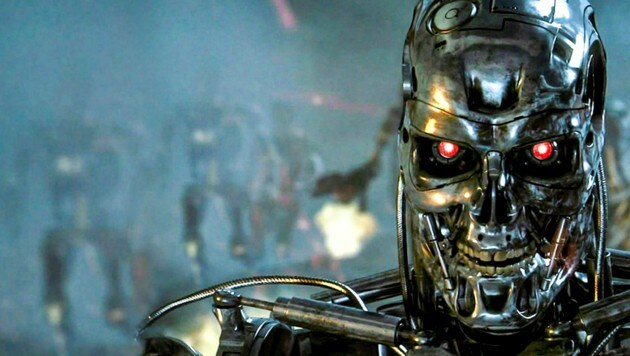

KI für US-Drohnen

Mitarbeiter-Protest gegen Googles „Kriegsgeschäft“

Zahlreiche Mitarbeiter von Google haben den US-Technologiekonzern aufgerufen, sich vom „Geschäft mit dem Krieg“ fernzuhalten. Google müsse klar erklären, dass weder der Internetriese noch seine Subunternehmen „jemals Kriegstechnologie herstellen“, heißt es in einer Petition, die bis Dienstag rund 4000 Angestellte unterzeichneten. Darin fordern sie Google auf, Drohnenprogramme des US-Militärs nicht mithilfe künstlicher Intelligenz zu verbessern. Mehrere Entwickler reichten bereits aus ethischen Gründen ihre Kündigung ein.

Hintergrund der Proteste ist das sogenannte Project Maven, bei dem laut US-Medien intelligente Algorithmen bei der Erkennung und Unterscheidung von Menschen in Drohnenvideos für das Pentagon zum Einsatz kommen. „Wir fordern, dass das ‘Project Maven‘ gestoppt wird“, heißt es in der Petition, von der Kopien im Internet veröffentlicht wurden. „Wir glauben, dass Google nicht im Geschäft mit dem Krieg sein sollte.“

Das Unternehmen war am Dienstag für eine Stellungnahme zunächst nicht zu erreichen. Unterstützung für die Petition kam von der US-Bürgerrechtsorganisation Electronic Frontier Foundation (EFF) und dem International Committee for Robot Arms Control (ICRAC), das sich dafür einsetzt, die militärische Nutzung von Robotern zu begrenzen.

„Nur kleiner Schritt zum automatisierten Töten“

Auch wenn die durch künstliche Intelligenz gewonnenen Erkenntnisse noch einmal von menschlichen Analysten überprüft werden sollten, könne diese Technologie den Weg für automatisierte Zielerfassungssysteme bei Kampfdrohnen ebnen, schrieb das ICRAC in einem offenen Brief.

„Wenn Befehlshaber des Militärs zu der Erkenntnis gelangen, dass die Algorithmen verlässlich sind, gibt es die Versuchung, die Überprüfung durch Menschen für diese Systeme abzuschwächen oder sogar abzuschaffen.“ Dann sei die Menschheit „nur einen kleinen Schritt davon entfernt, autonomen Drohnen zu erlauben, automatisiert zu töten - ohne menschliche Aufsicht oder aussagekräftige Kontrolle“, warnte das Komitee.

„Düsteres Bild“

Google habe in der Vergangenheit betont, die Arbeit des Technologiekonzerns zur Verbesserung der Fähigkeiten zur Objekterkennung diene keinen Angriffszwecken, erklärte die EFF. Nun zeige sich allerdings ein „düsteres Bild“, schrieben Cindy Cohn und Peter Eckersley in einem Online-Beitrag im vergangenen Monat. Durch die von Google bereitgestellte Technologie könnten von Drohnen erkannte Objekte oder Menschen für eine Überprüfung durch Menschen markiert werden. Dies könne dann in einigen Fällen tatsächlich zu Luftangriffen führen, schrieben Cohn und Eckersley. Dadurch stehe aus ethischer Sicht enorm viel auf dem Spiel - „selbst wenn in dieser Tötungskette noch weiter oben Menschen sind“.

Sowohl EFF als auch ICRAC riefen dazu auf, eine ernsthafte Debatte über die Notwendigkeit ethischer Rahmenbedingungen für die Nutzung künstlicher Intelligenz in der Waffentechnik zu führen. Diese Debatte sei von entscheidender Bedeutung und müsse international geführt werden. Firmen wie Google müssten sich der Folgen ihres Handels bewusst sein und von den Militärvertretern Verhaltensstandards und Verantwortlichkeit einfordern - ebenso wie von sich selbst.

krone.tv

Mehr Elektronik

Kommentare

Da dieser Artikel älter als 18 Monate ist, ist zum jetzigen Zeitpunkt kein Kommentieren mehr möglich.

Wir laden Sie ein, bei einer aktuelleren themenrelevanten Story mitzudiskutieren: Themenübersicht.

Bei Fragen können Sie sich gern an das Community-Team per Mail an forum@krone.at wenden.