Hilfe im Konflikt

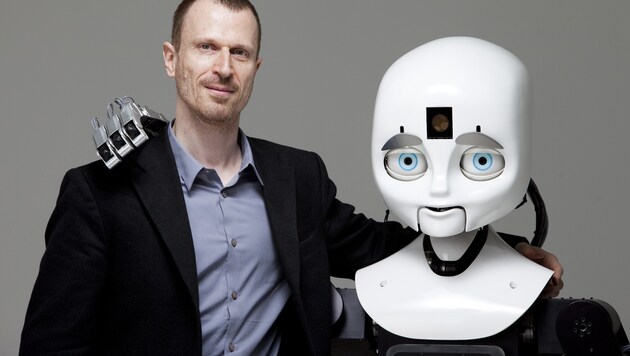

Experte fordert “moralischen Kompass” für Roboter

"Wenn wir mit autonomen Maschinen, vor allem sozialen Robotern, zusammenarbeiten und wohnen werden, dann müssen sich diese Maschinen auf uns und unser normatives Verhalten einstellen können", so der Professor für Kognitions- und Computerwissenschaft an der Tufts University bei Boston im US-Bundesstaat Massachusetts. "Wenn das nicht der Fall ist, befürchte ich, dass wir Probleme bekommen werden, dass uns die Maschinen verletzen könnten, emotional oder physisch."

Das Team um Scheutz - von Logikern, Philosophen, Psychologen bis Rechtsexperten - erforscht zum einen Möglichkeiten, wie man mit Robotern in natürlicher Sprache kommunizieren, und zum anderen, wie man ihr Verhalten mit "moralischen Algorithmen" stets berechenbar machen kann. Das sei schon deshalb ein kompliziertes Unterfangen, weil es jeden Aspekt der Kontrollarchitektur betreffe. Ein zentrales zu lösendes Problem seien moralische Dilemma-Situationen, bei denen ein rein logisches Vorgehen im Widerspruch enden würde.

Unvorhersehbare Geschehnisse in der "offenen" Welt

Während in einer geschlossenen Umgebung wie einer Fabrikhalle die Handlungsoptionen und der Aktionsradius eines Roboters ziemlich eindeutig definiert werden können, sind die Geschehnisse in der "offenen" Welt schlicht nicht vorhersehbar. Wie also soll sich zum Beispiel ein Roboter verhalten, der bei einer Katastrophe dringend benötigte Medikamente von A nach B bringen soll, unterwegs aber einen schwer verletzten Menschen vorfindet, den es zu versorgen gilt?

"Wenn etwas passiert und der Roboter keine Verbindung mit einem menschlichen Supervisor hat, dann muss er trotzdem irgendeine Lösung finden, wie er mit der Situation umgeht", erklärt Scheutz. Ähnlich wie Menschen sollten Roboter in der Lage sein, eine Situation an Ort und Stelle zu bewerten und anhand von allgemeinen Prinzipien eine Entscheidung zu treffen - und sie anschließend rechtfertigen können: "Wenn er gefragt wird, warum er so gehandelt hat, muss er sagen können, warum."

Allgemeine ethische Grundlagen

Angesichts durchaus unterschiedlicher Vorstellungen von Moral sei es aber nicht Aufgabe der Forscher, das ethische System vorzuschreiben, sondern die technischen Rahmenbedingungen zu schaffen. Einer der vielen Ausgangspunkte, von denen aus man sich an einen moralisch kompetenten Roboter annähere, seien deshalb ganz allgemeine Rechtsgrundlagen, etwa, dass man Menschen nicht angreifen oder herumschubsen darf. Mithilfe von sozialpsychologischen Experimenten beobachten die Forscher zunächst, wie Menschen auf Roboter reagieren und mit ihnen interagieren, beispielsweise welche Auswirkungen das Erscheinungsbild der Maschine auf die Einstellungen von Versuchspersonen hat.

Erst vor kurzem haben die Forscher etwa herausgefunden, dass in dilemmaartigen Szenarien Menschen und Roboter unterschiedlich bewertet werden. In einer Situation, in der ein Mensch entweder fünf Personen retten kann, indem er eine Person "opfert", oder nichts macht und daraufhin alle fünf sterben, hätten die Versuchspersonen den "inaktiven" Menschen nicht zur Verantwortung gezogen. Umgekehrt wurde es als falsch angesehen, wenn der Roboter tatenlos blieb. "Das ist eine interessante Asymmetrie", so Scheutz, "es scheint, als würden wir den Roboter als jemanden ansehen, der eine Situation schnell durchdenken kann und der auch handeln soll."

krone.tv

Mehr Elektronik

Kommentare

Da dieser Artikel älter als 18 Monate ist, ist zum jetzigen Zeitpunkt kein Kommentieren mehr möglich.

Wir laden Sie ein, bei einer aktuelleren themenrelevanten Story mitzudiskutieren: Themenübersicht.

Bei Fragen können Sie sich gern an das Community-Team per Mail an forum@krone.at wenden.